|

|

| RecurrentNeuralLayer () |

| | コンストラクタ

|

| |

| | RecurrentNeuralLayer (RecurrentNeuralLayer &&r) |

| | ムーブコンストラクタ

|

| |

|

| ~RecurrentNeuralLayer () |

| | デストラクタ

|

| |

| void | PropagateForward (const std::array< Matrix< 1, N >, W+2 > &zprev, const size_t t) |

| | 順伝播計算(ベクトル入出力版)

|

| |

| void | PropagateBackward (const std::array< Matrix< 1, P >, W+2 > &dLdznext, const size_t t) |

| | 逆伝播計算(入力層と内部層用,ベクトル入出力版)

|

| |

| void | PropagateBackward (const Matrix< 1, P > &dLdenext, const size_t t) |

| | 逆伝播計算(-)

|

| |

|

void | PropagateForwardForOutput (const std::array< Matrix< 1, N >, W+2 > &zprev) |

| | 順伝播計算(出力層用,ベクトル入出力版)

|

| |

| void | PropagateBackwardForOutput (const Matrix< 1, P > &r) |

| | 出力の重み誤差ベクトル計算(出力層用,ベクトル入出力訓練版)

|

| |

| void | UpdateWeightAndBias (const std::array< Matrix< 1, N >, W+2 > &zprev) |

| | 重み行列とバイアスベクトルの更新

|

| |

| void | UpdateWeightAndBiasForOutput (const std::array< Matrix< 1, N >, W+2 > &zprev) |

| | 重み行列とバイアスベクトルの更新(出力層用)

|

| |

|

void | ClearStateVars (void) |

| |

| void | InitWeight (const size_t Nprev) |

| | 重み行列の初期化

|

| |

|

void | DispWeightAndBias (void) |

| | 重み行列とバイアスベクトルの表示

|

| |

|

void | DispError (void) |

| |

|

void | GenerateDropMask (void) |

| | ドロップアウトマスクの生成

|

| |

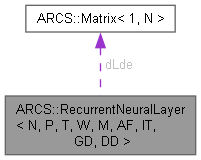

template<size_t N, size_t P, size_t T, size_t W, size_t M,

ActvFunc AF,

NnInitTypes IT = NnInitTypes::XAVIER,

NnDescentTypes GD = NnDescentTypes::MOMENTUM,

NnDropout DD = NnDropout::DISABLE>

class ARCS::RecurrentNeuralLayer< N, P, T, W, M, AF, IT, GD, DD >

再帰ニューラルレイヤクラス

- テンプレート引数

-

| N | 入力チャネル数 |

| P | パーセプトロン数 |

| T | 時系列方向のデータ数 |

| W | 入力ウィンドウ幅 |

| M | ミニバッチ数 |

| AF | 活性化関数の種類 |

| IT | 初期化のタイプ |

| GD | 勾配降下法のタイプ |

| DD | ドロップアウト動作フラグ |